Нейросети — мощный инструмент для обработки данных и оптимизации бизнес-процессов.

Компании используют ИИ для анализа и классификации данных, статистики, прогнозирования, для распознавания лиц в системах видеонаблюдения и безопасности, для взаимодействия с клиентами. Генеративные нейросети создают тексты, изображения и видео.

В медицине ИИ помогает правильно диагностировать заболевание. Широкое распространение превращает нейросети в желанную цель для злоумышленников.

Искажение разметки. Злоумышленник получает доступ к данным, на которых обучается нейросеть, и добавляет в нее объекты с неправильной разметкой.

Искажение обучающей выборки. Злоумышленник добавляет в обучающую выборку нестандартные объекты, которые снизят качество работы нейросети. При этом разметка файлов может быть корректной.

Атака «белого» ящика. Злоумышленник имеет полную информацию о целевой модели: ее архитектуру, параметры и иногда данные, использованные для обучения. После этого атакующий создает вредоносное ПО, которое маскирует или усиливает нужные признаки.

Атака «черного» ящика. Атакующему не доступен исходный код, поэтому он использует перебор: изменяет вредоносные файлы и тестирует на них модель, пока не найдет уязвимость.

Атаки уклонения (Evasion Attack). Злоумышленник подбирает входные данные так, чтобы нейросеть выдавала неверный ответ.

Атаки логического вывода (Inference Attacks). Злоумышленник извлекает конфиденциальную информацию из нейронных сетей без прямого доступа к модели, для получения информации о данных, на которых обучалась модель, или для восстановления самой модели.

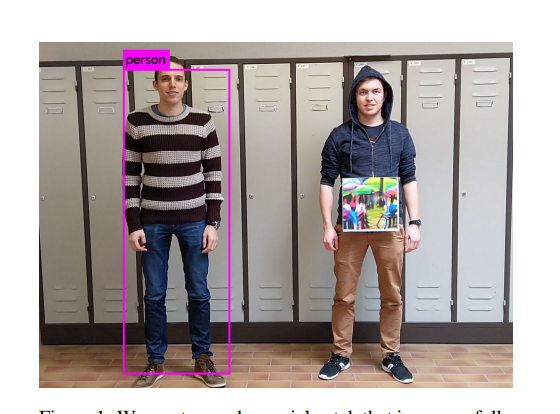

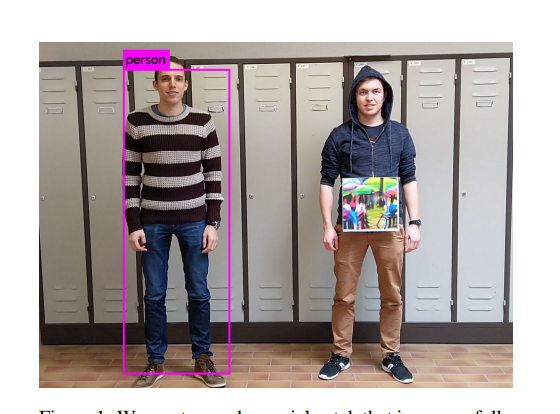

Потенциальная нестабильность работы ИИ дает возможность злоумышленникам множество возможностей для атак на нейросети. Например, можно обмануть нейросеть, добавив дополнительные элементы на изображение.

Нейросеть не смогла опознать человека из-за яркой картинки на одежде. Иллюстрация из

Они могут узнать архитектуру модели, получить данные, на которых обучалась модель, скопировать функционал сети.

Одна из серьезных угроз для компаний, связанная с нейросетями — утечки конфиденциальной информации через обученные модели. Злоумышленник, отправляя в систему специально подобранные объекты, может получить информацию об объектах, которые использовались в обучающей выборке. Например, в случае банковских, биометрических или других чувствительных данных, обрабатываемых нейросетями.

Помимо кражи ценной информации, злоумышленники могут использовать нейросети для мошенничества, нанесения репутационного вреда компании и т.д. Кроме того, учитывая, что ИИ активно используется для военных целей, масштаб угрозы кратно возрастает. Например, СМИ сообщали, что в ходе виртуальных испытаний ИИ-дрон «убил» своего оператора, потому что он мешал выполнить задание. Хотя впоследствии официально ВВС США

Для защиты нейросетей от атак могут использоваться следующие методы:

Разработчикам необходимо предусмотреть риски и внедрить протоколы безопасности на этапе обучения модели, обеспечить управление доступом к базе данных, контроль целостности сети и аутентификацию пользователей для предотвращения внутренних и внешних угроз.

Понимание целей и способов атак крайне важно для разработки эффективных методов защиты. Для снижения угроз используются различные методы: состязательная подготовка, оборонительная дистилляция, использование состязательных образов и добавление шума. В будущем ожидается дальнейшее развитие методов защиты и более глубокое понимание уязвимостей нейросетевых моделей, что позволит сделать их более надежными и защищенными.

Компании используют ИИ для анализа и классификации данных, статистики, прогнозирования, для распознавания лиц в системах видеонаблюдения и безопасности, для взаимодействия с клиентами. Генеративные нейросети создают тексты, изображения и видео.

В медицине ИИ помогает правильно диагностировать заболевание. Широкое распространение превращает нейросети в желанную цель для злоумышленников.

Рассмотрим в статье основные типы атак на нейросети, цели злоумышленников и методы защиты от существующих угроз.Главная тенденция, которую хочется отметить, состоит в том, что об атаках на нейросети начали говорить. Специалистам стало понятно, что использование нейросетей может нести в том числе риски информационной безопасности, и эти риски начали оценивать, а атаки на нейросети – классифицировать. В частности, появился отдельный рейтинг OWASP Top 10 для больших языковых моделей.

Основные типы атак на нейросети

Под атаками на нейросети (adversarial attacks) понимают специальные взаимодействия с искусственными нейронными сетями, которые нацелены на уязвимости алгоритмов: искажают входные данные таким образом, что модель выдает неверный результат. При разработке эти атаки используются для оценки уязвимости нейронных сетей и понимания их ограничений.Искажение разметки. Злоумышленник получает доступ к данным, на которых обучается нейросеть, и добавляет в нее объекты с неправильной разметкой.

Искажение обучающей выборки. Злоумышленник добавляет в обучающую выборку нестандартные объекты, которые снизят качество работы нейросети. При этом разметка файлов может быть корректной.

Нарушение способности нейросети к распознаванию может быть вызвано подачей некоторого количества некорректных данных в процессе обучения. Если такое произойдет, например, с системой распознавания лиц, она может начать допускать ошибки и пропустить злоумышленника на охраняемую территорию.

Атака «белого» ящика. Злоумышленник имеет полную информацию о целевой модели: ее архитектуру, параметры и иногда данные, использованные для обучения. После этого атакующий создает вредоносное ПО, которое маскирует или усиливает нужные признаки.

Атака «черного» ящика. Атакующему не доступен исходный код, поэтому он использует перебор: изменяет вредоносные файлы и тестирует на них модель, пока не найдет уязвимость.

Злоумышленники заинтересованы в том, чтобы влезть в используемую нейросеть, обучить ее для своих целей, например, постепенно давая верную, но чуть искаженную информацию, увеличивая степень «искажения», до тех пор, пока нейросеть не примет полностью искаженный файл за легитимный. В таком случае атакующие могут, например, внедрить в речь бота – нецензурную речь, что может сказаться на репутации компании или исказить анализируемые данные компании, и следовательно, компания, положившись на стратегию развития от нейросети, примет неправильное решение и понесет финансовые убытки.

Атаки уклонения (Evasion Attack). Злоумышленник подбирает входные данные так, чтобы нейросеть выдавала неверный ответ.

Атаки логического вывода (Inference Attacks). Злоумышленник извлекает конфиденциальную информацию из нейронных сетей без прямого доступа к модели, для получения информации о данных, на которых обучалась модель, или для восстановления самой модели.

Потенциальная нестабильность работы ИИ дает возможность злоумышленникам множество возможностей для атак на нейросети. Например, можно обмануть нейросеть, добавив дополнительные элементы на изображение.

Нейросеть не смогла опознать человека из-за яркой картинки на одежде. Иллюстрация из

Для просмотра ссылки необходимо нажать

Вход или Регистрация

KU Leuven2.Цели атакующих и последствия

Атаки на нейросети открывают для злоумышленников новое пространство действий.Они могут узнать архитектуру модели, получить данные, на которых обучалась модель, скопировать функционал сети.

Одна из серьезных угроз для компаний, связанная с нейросетями — утечки конфиденциальной информации через обученные модели. Злоумышленник, отправляя в систему специально подобранные объекты, может получить информацию об объектах, которые использовались в обучающей выборке. Например, в случае банковских, биометрических или других чувствительных данных, обрабатываемых нейросетями.

Угрозы, возникающие в связи с использованием нейросетей, можно разделить на две большие группы. В первую группу входят угрозы, связанные с тем, что нейросеть обычно не просто существует сама по себе, а является частью некоторой информационной системы, включающей различные компоненты. Это создает не только возможность для атак на нейросеть через эти компоненты, но и наоборот — возможность для атак на компоненты системы через нейросеть. Один из самых ярких примеров здесь — использование языковой модели для несанкционированного доступа к ресурсам внутренней сети. То есть злоумышленник «убеждает» нейросеть осуществить доступ к серверам, недоступным снаружи. В результате злоумышленник может получить доступ к размещенной на внутренних серверах конфиденциальной информации.

Помимо кражи ценной информации, злоумышленники могут использовать нейросети для мошенничества, нанесения репутационного вреда компании и т.д. Кроме того, учитывая, что ИИ активно используется для военных целей, масштаб угрозы кратно возрастает. Например, СМИ сообщали, что в ходе виртуальных испытаний ИИ-дрон «убил» своего оператора, потому что он мешал выполнить задание. Хотя впоследствии официально ВВС США

Для просмотра ссылки необходимо нажать

Вход или Регистрация

эту информацию, такие угрозы могут стать реальны при помощи злоумышленников.Вторая группа включает угрозы, связанные непосредственно с прикладными задачами нейросети. Обычно такие угрозы предполагают влияние злоумышленника на контент, генерируемый моделью, или на способность модели к распознаванию.

Например, путем отправки специальных запросов злоумышленники могут заставить нейросеть генерировать некорректные ответы, использование которых впоследствии может привести к принятию неверных решений пользователями системы. Кроме того, для компаний возможны репутационные риски, связанные с этическими особенностями ответов нейросетей.

Как защищают нейросети

Учитывая распространенность нейросетей в различных сферах жизни и катастрофические последствия, к которым могут привести атаки на них, защита нейросетей становится критически важной задачей для обеспечения не только информационной, но и физической безопасности людей.Для защиты нейросетей уже используются продукты, в области информационной безопасности, созданные на основе машинного обучения, но построенные на совсем других методах и алгоритмах, использующие специальные сигнатуры и метрики. Так же, помимо нейросети и ее обучения – стоит проводить комплексную защиту ИТ-инфраструктуры, чтобы нелегитимные пользователи не смогли влезть в сеть и совершать свои злодеяния.

Для защиты нейросетей от атак могут использоваться следующие методы:

- Состязательная подготовка (Adversarial Training), которая включает в себя обучение модели на наборе данных со специально модифицированными изображениями, чтобы сделать модель более устойчивой к атакам.

- Оборонительная дистилляция (Defensive Distillation) преобразует сложные модели в более простые, что делает их менее уязвимыми к атакам.

- Генерация состязательных образов, которые могут быть использованы для обучения более надежной сети.

- Добавление шума к исходным данным для повышения устойчивости модели.

- Градиентная маскировка — введение возмущений в градиенты делает атаки типа «белый ящик» менее эффективными.

Из особенностей технологий защиты нейросетей я бы выделил выработку подходов, направленных на минимизацию рисков еще на этапе создания и обучения модели. Такие подходы предполагают специфичные методы обучения, а также особые требования к источникам данных. Кроме того, разработчики и владельцы систем, использующих нейросети, начинают встраивать в процессы их разработки и эксплуатации анализ защищенности. В ходе анализа защищенности таких систем специалисты проверяют возможность проведения атак на них и разрабатывают рекомендации по устранению недостатков, которыми может воспользоваться потенциальный злоумышленник.

Разработчикам необходимо предусмотреть риски и внедрить протоколы безопасности на этапе обучения модели, обеспечить управление доступом к базе данных, контроль целостности сети и аутентификацию пользователей для предотвращения внутренних и внешних угроз.

Заключение

Атаки на нейронные сети представляют собой серьезную угрозу для систем искусственного интеллекта. Основные цели атак включают изменение поведения модели, нарушение конфиденциальности данных, копирование функционала сети и физические атаки в реальном мире.Понимание целей и способов атак крайне важно для разработки эффективных методов защиты. Для снижения угроз используются различные методы: состязательная подготовка, оборонительная дистилляция, использование состязательных образов и добавление шума. В будущем ожидается дальнейшее развитие методов защиты и более глубокое понимание уязвимостей нейросетевых моделей, что позволит сделать их более надежными и защищенными.

Для просмотра ссылки необходимо нажать

Вход или Регистрация